Cómo no hacer un

ranking de universidades. El caso peruano

How not to make a ranking of universities. The Peruvian case

Recibido: 27 de julio 2020

Evaluado: 01 de septiembre 2020

Aceptado: 03 de noviembre 2020

Ángel Ramón

Velázquez Fernández

https://orcid.org/0000-0001-5293-3353

Universidad de

San Martín de Porres

Nérida Gladys Rey Córdova

https://orcid.org/0000-0002-5646-4985

Universidad de San Martín de Porres,

Universidad César Vallejo,

Universidad San Ignacio de Loyola

Miguel Ángel Vidal Gonzáles

https://orcid.org/0000-0002-7409-7015

Universidad de San Martín de Porres

DOI: https://doi.org/10.35756/educaumch.202016.160

Como citar.

Velázquez Fernández, Ángel, Rey Córdova, N., & Vidal Gonzáles, M.

(2020). Cómo no hacer un ranking de universidades. El caso

peruano. Revista EDUCA UMCH, (16), 29-45. https://doi.org/10.35756/educaumch.202016.160

Resumen

El objetivo de este estudio fue analizar el cumplimiento de los Principios de Berlín por los rankings elaborados por Sunedu, así como evaluar su confiabilidad, comparándolos con otros rankings (THE, SIR y QS). El diseño ha sido no experimental, descriptivo, con un enfoque mixto. La muestra estuvo conformada por veinte universidades peruanas clasificadas en los rankings Sunedu, seleccionadas de manera no probabilística, en función de los objetivos de la investigación. Como resultados principales se obtuvo que la utilidad de los rankings Sunedu es mínima, pues, al centrarse solo en la investigación, no disminuye la asimetría de información sobre la calidad del proceso de formación, por lo que a los jóvenes y padres de familia no les es posible tomar decisiones adecuadas sobre la base de sus resultados. Su única función ha sido la de clasificar a las universidades según un conjunto de criterios subjetivos seleccionados por un grupo de expertos, provenientes de un reducido número de universidades. Asimismo, se aprecia que los rankings Sunedu padecen de una serie de debilidades que violan las recomendaciones de los Principios de Berlín y reproducen los aspectos negativos de estas clasificaciones, que han sido advertidos por diversos autores especialistas sobre la materia.

Palabras claves: ranking universitario,

calidad, investigación científica

Summary

The objective of this study was to analyze

compliance with the Berlin Principles by the

rankings prepared by Sunedu, as well as to evaluate their reliability,

by comparing them with other rankings

(THE, SIR y QS). The design has been non-experimental, descriptive, with a mixed approach. The sample

consisted of twenty Peruvian universities classified in the Sunedu rankings,

selected in a non-probabilistic way, based on the research

objectives. As main results,

it was obtained that the usefulness of the Sunedu rankings is minimal, since, by focusing only on research, the

asymmetry of information on the quality of the

training process does not decrease, therefore. it is not possible for young people and parents

to make adequate decisions based on their results. Its sole function has

been to classify universities based

on a set of subjective criteria selected by a group of experts

from a small number of

universities. Likewise, it is appreciated that the Sunedu rankings suffer from

a series of weaknesses that violate the recommendations of the Berlin Principles and reproduce

the negative aspects of these classifications, which had already been warned by various

specialist authors on the subject.

Keywords: university

ranking, quality, scientific research

Introducción

Recientemente, como parte del II Informe Bienal sobre la Realidad Universitaria en el Perú, se publicó el Ranking nacional de universidades sobre investigación 2020 (Sunedu, 2020). Esta publicación se realiza en consonancia con la Ley 30220, Ley Universitaria, la cual en su inciso 15.15 establece, entre las funciones de la Superintendencia Nacional de Educación Superior Universitaria (Sunedu) la publicación de un informe bienal sobre la realidad universitaria, el cual debe incluir un “ranking universitario, respecto del número de publicaciones indexadas, entre otros indicadores” (Ley 30220, 2014).

No obstante, es necesario precisar que el mencionado ranking -en adelante Ranking Sunedu- no cumple de manera integral con el mandato de la ley, pues como su propio nombre lo indica solo toma en cuenta la investigación.

Una característica del Informe Bienal es que, a pesar de hablar del “ranking”, en singular, en realidad se presentan dos, uno basado en la base de datos Scopus y el otro en Web of Science, sin que haya diferencias significativas en las posiciones de las universidades entre ambas clasificaciones (Sunedu, 2020, pp. 109-110). En el presente documento, toda la información analizada corresponde el ranking basado en Scopus.

En referencia a la utilidad de los rankings, el Informe Bienal plantea:

… los rankings universitarios han ido ganando relevancia en las últimas décadas, al ser cada vez más empleados por los estudiantes y sus familias para la toma de decisiones sobre dónde seguir su educación universitaria, por los académicos para decidir respecto al desarrollo de su carrera profesional, por los funcionarios públicos para la asignación de recursos destinados a docencia e investigación …, actualmente, muchas universidades tienen en cuenta este instrumento para la toma de decisiones respecto a estrategias de gestión, planificación e implementación de mejoras. Incluso algunas universidades se plantean metas estratégicas de acuerdo con la posición que ocupan en el ranking… Además, los rankings promueven la actividad investigadora, en el sentido de que los docentes se ven incentivados a desarrollar cada vez más publicaciones, con el objetivo de que su universidad sea reconocida entre el grupo de instituciones que presenta mayor producción científica y por ende ocupe una mejor posición en el ranking… (Sunedu, 2018, pp. 87-88).

No es común la elaboración de rankings universitarios por agencias gubernamentales. En la búsqueda realizada en la web, sobre algunos países latinoamericanos no pudimos encontrar ninguno; y todas las referencias a las posiciones de sus países se refieren a los que han sido elaborados por instituciones privadas, tales como Scimago Institutions Ranking (SIR), Times Higher Education Ranking (THE) Academic Ranking of World Universities (ARWU) y Quacquarelli Symonds (QS), entre otros. el único antecedente encontrado, a nivel latinoamericano, es precisamente peruano. En el año 2005, a propuesta del Instituto Internacional para la Educación

Superior en América Latina y el Caribe (IESALC), de la UNESCO, la Asamblea Nacional de Rectores (ANR) encargó al Dr. Luis Piscoya Hermoza, que realizara una investigación con el propósito de realizar una experiencia piloto en el Perú, que pudiera ser aplicable a otros países de América Latina (Piscoya, 2007). En las fuentes analizadas, no se han encontrado referencias sobre la aplicación de la metodología resultante de ese estudio, en otros países.

Los rankings de universidades han recibido severas críticas por parte de profesionales del mundo académico, por lo que llama aún más la atención su inclusión en una ley universitaria. A continuación, algunos ejemplos de esos cuestionamientos.

Ordorika (2015) se pronuncia sobre la selección de los indicadores y los sesgos que ello puede provocar:

En la selección de indicadores y fuentes de información, en las metodologías para la construcción de indicadores y en la ponderación de los mismos se ocultan limitaciones y sesgos que no se señalan explícitamente a la hora de presentar resultados (p.8).

Los sesgos descritos hacen evidente que el patrón de comparación que da cuerpo a la mayoría de los rankings internacionales está sustentado en un modelo de universidad: el de la universidad elitista de investigación norteamericana, simbolizado por instituciones como Harvard, Stanford o Berkeley. Este modelo… se caracteriza por su fuerte orientación a la investigación y el posgrado, así como por los vínculos estrechos entre algunas áreas de investigación con empresas y actividades económicas en distintos campos (p.9).

Usher y Savino (2006) se refieren a la relación entre los indicadores y el concepto de calidad cuando expresan que:

Al seleccionar un conjunto de indicadores en particular y asignar a cada uno una determinada ponderación, los autores de estos rankings imponen una definición específica de calidad a las instituciones que están clasificando. El hecho de que pueda haber otros indicadores legítimos o combinaciones de indicadores, por lo general se omite silenciosamente.

Curiosamente, sin embargo, hay poco acuerdo entre los autores de estos indicadores en cuanto la definición de “calidad”. Los principales sistemas de ranking del mundo tienen muy poca relación entre ellos, si es que la tienen, y usan indicadores y coeficientes de ponderación muy distintos para llegar a medida de calidad (p.33-34).

Delgado 2012) es bastante incisivo al pronunciarse sobre los elaboradores de los rankings y sus efectos sobre el mundo académico.

“… los rankings de universidades han pasado a ser

elaborados por especialistas, menos especialistas y, en última instancia, casi

por cualquiera que tenga interés... o intereses, y esto último sí que podría

resultar preocupante” (p. 44).

Según

Hazelkorn (2009), los rankings han inducido a los

gobiernos y las instituciones de educación superior (IES) a adoptar soluciones

simplistas y sesgar las agendas y políticas, para aumentar la productividad y

eficiencia de la investigación. La autora plantea que la historia de los

rankings muestra que medir las cosas incorrectas puede producir distorsiones.

Al valorar algunas investigaciones más que otras, los rankings (y sistemas

similares de evaluación de la investigación) reproducen las concepciones clásicas del

conocimiento y las relaciones de poder; fomentan el regreso a la investigación

de la "torre de marfil"

realizada por las élites en instituciones seleccionadas en un momento en que los problemas

globales complejos y los objetivos

de las políticas requieren la participación de equipos interdisciplinarios con diversas perspectivas y experiencias… (pp. 11-12).

Krüger y Molas (2010) distinguen dos tipos ideales

de universidad. El primero sería el de investigación

intensiva y estudios de posgrado,

que estaría orientado a la economía

y a la sociedad del

conocimiento. El segundo sería de tipo vocacional masificado, centrado en la formación para la economía

empresarial, la informática y las profesiones de alta demanda en los servicios públicos

como educación y sanidad. Los autores plantean

que los rankings globales dan preferencia al primer tipo ideal e

influyen normativamente en muchas

políticas nacionales, y resaltan que este tipo de clasificaciones es, por su

propia naturaleza, injusta (Sección Introducción, párrafos 7 y 8).

Bookstein. et al. (2010) critican la variabilidad de los resultados anuales y llegan a la conclusión de que la mayor parte del sistema de calificación THE muestra variaciones inaceptables de un año a otro, por lo que no es probable que sean un componente útil de ningún enfoque racional de la administración. Según este autor, esa inestabilidad solo puede fortalecer la crítica existente del sistema de clasificación por evaluadores anteriores (p. 99).

Algunos inconvenientes observados por otros académicos y por el propio autor de este documento son los siguientes:

•

No se

explica de manera transparente el origen –las fuentes– de la información (quién

dice qué sobre cada institución en cada país).

Puede crear en las

universidades la propensión a enfocar su gestión en la mejora en el ranking y no

en la calidad académica en general.

Las revistas consideradas

en las bases de datos para la información bibliométrica son en su mayoría, en

lengua inglesa, lo que pone en desventaja a los académicos de otras lenguas,

así mismo, se enfocan casi preponderantemente en Scopus y Web of Science,sin considerar otras bases

de datos, libros y repositorios institucionales, que también forman parte de la

producción científica universitaria. Esto provoca que los autores traten de enfocarse

en los requerimientos y tendencias de ciertas revistas y no en los que se

requieren para potenciar el desarrollo de sus países.

A partir de los cuestionamientos, el European Centre for Higher Education de la UNESCO (CEPES) y el Institute for Higher Education Policy de los Estados Unidos de Norteamérica, convocaron a una reunión de expertos en 2006, que produjo como resultado, los Principios de Berlín, los cuales constituyen una serie de recomendaciones que se sugiere tomar en cuenta para la elaboración de los rankings universitarios (Berlin Principles on Ranking of Higher Education Institutions, 2006).

El objetivo del presente estudio consiste en analizar el cumplimiento de estos principios en los rankings elaborados por la Sunedu, así como evaluar su confiabilidad, mediante la comparación con los rankings internacionales SIR, QS y THE

Metodología de la investigación

El estudio es descriptivo y comparativo, con enfoque mixto. Se basa, en primer lugar, en la comparación de la metodología y los resultados de los rankings de la Sunedu, con los Principios de Berlín sobre los rankings de instituciones de educación superior.

En segundo lugar, se comparan los resultados del Ranking Sunedu con los rankings internacionales más relevantes: THE, SIR y QS.

Resultados y discusión

Análisis de la correspondencia del Ranking Sunedu 2020 con los principios de Berlín

El análisis se centra, no en la totalidad de principios sino en aquellos que se han considerado más relevantes para los fines del presente estudio. La numeración no es consecutiva, sino corresponde a la de cada principio en el documento original. En algunas ocasiones se analizan los principios de manera individual y en otras, varios de manera conjunta, por el grado de relación que existe entre ellos.

Principio 1. Los rankings

constituyen solo una entre varias aproximaciones que se pueden utilizar para evaluar el

rendimiento de las instituciones universitarias. (Berlin Principles on Ranking of Higher Education Institutions, 2006).

En Perú se utilizan varios procedimientos para la evaluación de la calidad de las universidades. Uno de ellos es el licenciamiento institucional que lleva a cabo la Sunedu. Este proceso, iniciado en 2016, es obligatorio y partió del supuesto de que todas las universidades, independientemente de su antigüedad o cualquier otro criterio deben obtener una nueva licencia para funcionar. El referente para la evaluación son las condiciones básicas de calidad (CBC) establecidas de manera genérica en la Ley

Universitaria y desarrolladas, de manera específica, en el Modelo

de Licenciamiento y su implementación en el Sistema Universitario Peruano

(Ley 30220, 2014; Sunedu, 2015).

La licencia puede ser otorgada por seis, ocho o diez años, pero lo contradictorio en este caso, ha sido el hecho de que esos períodos no se otorgan teniendo en cuenta el grado de cumplimiento de las CBC, sino basándose en dos criterios: el lugar ocupado por la universidad en el ranking Scimago (SIR) de Latinoamérica del año 2015 y varios indicadores relacionados con la carrera docente.

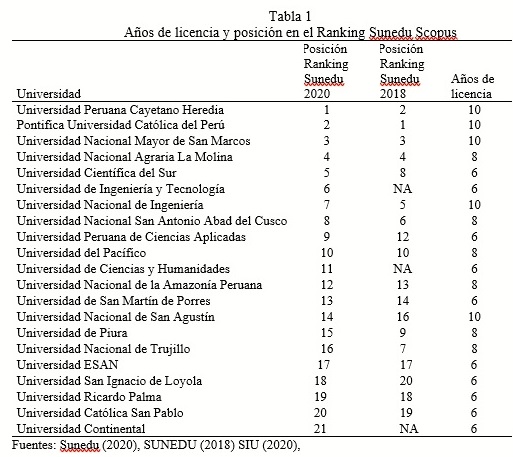

A continuación, se presenta una muestra de universidades con información sobre la posición ocupada en los rankings Sunedu 2020 y 2018, y los años de licencia obtenidos en el proceso de licenciamiento. Debe tenerse en cuenta que, las universidades obtuvieron su licencia entre los años 2016 y 2020, por lo que se ha considerado pertinente analizar los dos rankings elaborados en ese período.

Los resultados obtenidos fueron los siguientes:

Rho de Spearman para años de licencia y posición en el Ranking Sunedu 2018: - 0.721

Rho de Spearman para años de licencia y posición en el Ranking Sunedu 2020: -0.541

En ambos casos se obtiene una correlación negativa moderada entre los años de licencia y la posición ocupada en el ranking Sunedu, en alguna medida coincidente con la hipótesis de partida, aunque no llegan a ser correlaciones fuertes. Se observa, además, que la fortaleza de la correlación disminuye en 25% en 2020, con respecto a 2018, lo cual significa que las posiciones en los rankings, al basarse en los resultados de un año, no son indicadores idóneos para diferenciar períodos de licencia que van desde seis hasta diez años.

Principio 3. Reconocer

la diversidad de instituciones y asumir las diferentes misiones y objetivos de instituciones tomadas

en cuenta. Medidas

de calidad para instituciones

orientadas a la investigación, para ejemplo, son bastante diferentes de las que son apropiadas para instituciones que brindan amplio acceso a comunidades desatendidas (Berlin Principles on Ranking of Higher Education Institutions, 2006).

Principio 7. Elegir

indicadores según su relevancia y validez. La elección de los datos debe ser basado en el reconocimiento

de la capacidad de cada indicador para representar la calidad y fortalezas institucionales, así como la disponibilidad de datos. Sea claro sobre

por qué estos indicadores fueron

incluidos y lo que se supone que representan (Berlin Principles on Ranking

of Higher Education Institutions, 2006).

De manera general, a los rankings internacionales les cuesta mucho trabajo considerar las particularidades misionales de las universidades, dada la gran diversidad de instituciones que representan. Algunos de ellos, tienen un alto componente de investigación, tales como SIR (50%) y ARWU (70%). QS y THE tienen un menor componente de investigación de 15% y 36%, respectivamente. Estas últimas también utilizan encuestas de reputación a empleadores y académicos. THE también considera la proporción entre títulos (grados) de doctor y de licenciatura otorgados, así como a la proporción de doctores con respecto al total de docentes, entre otros indicadores. QS utiliza, además, la relación entre la cantidad de estudiantes y de docentes, y la proporción de docentes con doctorado. (SIR, 2020; QS, 2020; THE, 2020; Academic Ranking of World Universities, 2020).

1 Inferior en el sentido del valor absoluto del número. Una

posición inferior significa estar mejor en el

ranking.

En

el caso del Ranking Sunedu, era de esperarse que, al enfocarse en un solo país,

se hubieran podido considerar las realidades nacionales, pero este no ha sido

el caso. A pesar de que la ley manda que en el ranking se considere a las

publicaciones en revistas indexadas y otros indicadores, no se ha procedido de

esa manera (Ley 30220, 2014, inciso 15.15).

Sobre la ausencia de otros indicadores relevantes sobre la calidad universitaria, en el primer informe bienal, en el año 2018, sus autores plantearon:

Los logros de una universidad se pueden asociar a una variedad de dimensiones que van desde la calidad de empleo de los egresados hasta la generación de conocimiento a través de la investigación e innovación, pasando por otras dimensiones tales como extensión universitaria y los resultados académicos del proceso formativo.

… la clasificación propuesta no considera variables asociadas a los insumos con los cuales la universidad alcanza sus resultados... La razón por la cual no se incluyen estas variables es la carencia de información con los niveles necesarios de objetividad, estandarización y validación para el conjunto del sistema universitario. No obstante, está planificada su incorporación progresiva en futuras versiones del ranking a medida que se vaya obteniendo esta información, como también sucederá con el resto de las dimensiones citadas más allá de la investigación. (Sunedu, 2018, p.88).

A pesar de lo expuesto, en 2020 se repite la omisión, solo que esta vez se sincera el nombre y se le denomina “ranking de investigación…”.

Las razones por la cuales la SUNEDU no consideró otras dimensiones, además de la investigación, carecen de sustento. Actualmente existen el Sistema de Recolección de Información para Educación Superior (SIRIES), gestionado por el Ministerio de Educación, y el Sistema de Información Universitaria (SIU), gestionado por la Sunedu. Ambos proveen suficiente información que hubieran permitido obtener varios de los indicadores relacionados con los docentes y los estudiantes, como los utilizados por los rankings THE y QS. Otra información relevante se pudo obtener de los informes de los procesos de licenciamiento que se vienen realizando desde el año 2016.

Llama

la atención, que en 2018 no se consideró a Scopus, ni Scielo, ni otras bases de datos relevantes. En 2020 se incorpora

a Scopus, pero no a otras bases de datos. La

omisión más importante en ambos casos es la ausencia de otros tipos de

publicaciones como la gran mayoría de

las revistas y los libros de editoriales universitarias peruanas, las tesis

y los repositorios institucionales, entre otros. Esta disposición es contradictoria con lo establecido en el Reglamento de Calificación, Clasificación y Registro de los investigadores del Sistema Nacional de

Ciencia, Tecnología e Innovación Tecnológica

(RENACYT), para evaluar

a los investigadores, ya que en este se establece, que un artículo

científico en SCOPUS

equivale a un capítulo de libro y un libro

equivale a tres artículos en SCOPUS (CONCYTEC, 2019).

Una ventaja de un ranking nacional hubiera sido incluir rubros no considerados en las clasificaciones internacionales, pero al partir exclusivamente de una de sola base de datos2 de las que utilizan los rankings internacionales, no hace más que repetirse y reducir su pertinencia de manera significativa.

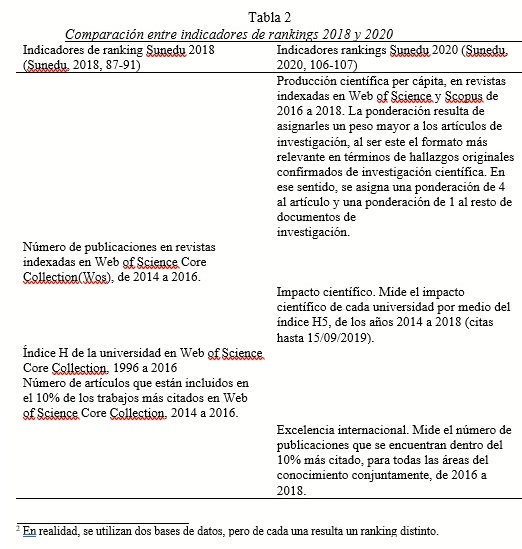

Para ilustrar mejor la relación entre los indicadores de los rankings 2018 y 2020, en la Tabla 2, se presenta una comparación resumida entre ellos.

2 En realidad, se utilizan

dos bases de datos, pero de cada una resulta

un ranking distinto.

Los resultados principales que resultan de la comparación son las siguientes:

a) Sunedu 2018 utiliza

cuatro indicadores y Sunedu 2020, tres; y aunque existen

similitudes entre algunos

de ellos, todos difieren entre sí.

b)

Las fuentes

de información son distintas (WoS para 2018; WoS y Scopus, para 2020).

c)

Los períodos

que se toman como referencia son diferentes, tanto entre rankings,

como entre indicadores del mismo ranking.

El que más difiere es el índice H, que en 2018 es de once

años y en 2020, de cinco.

d)

La

producción científica del primer informe se toma en valores absolutos y la del segundo

se refiere al per cápita,

en relación con el número de docentes.

En comparación con otros

rankings, QS utiliza el mismo indicador, pero solo tiene un peso de 5% y Sunedu 2020, 33.3% (QS,2020). THE también usa el per cápita, pero basándose en la cantidad

de estudiantes (THE, 2020). SIR mide la producción científica absoluta, pero acompañada de

múltiples criterios sobre el mismo indicador

(SIR, 2020).

e)

El definir

a “los artículos de investigación, … el formato

más relevante en términos de hallazgos originales confirmados de investigación científica”, y de este modo establecer

una proporción en del valor de 4 a 1 entre la investigación empírica y la teórica es una consideración subjetiva y arbitraria, que no se

compadece con la tradición científica internacional ni con la historia de la ciencia.

f)

El ranking

2020 es contradictorio con lo establecido en el Reglamento de Calificación, Clasificación y Registro de los investigadores del Sistema Nacional

de Ciencia, Tecnología e Innovación Tecnológica -

Reglamento RENACYT, tal como ha sido explicado en párrafos

anteriores.

A partir de lo expuesto, es evidente que no se cumple con los principios tres y siete, pues para la elección de los indicadores no se tomó en cuenta la diversidad de misiones y objetivos institucionales que caracterizan a la universidad peruana, concentrándose únicamente en un limitado número de indicadores sobre la investigación. De este modo se benefician las instituciones de élite centradas en la investigación, en detrimento de las que se enfocan principalmente en la formación. Esta debilidad concuerda con lo planteado por Ordorika (2015), Usher, y Savino(2006), Hazelkorn (2009) y Krüger y Molas(2010).

Asimismo, se pone de manifiesto que, dadas las importantes diferencias entre los rankings SUNEDU 2018 y 2020:

a)

No es

posible tomarlos como referencia para medir la evolución de la producción científica de una institución de un período a otro.

b)

Al medir

solo indicadores de investigación, no proveen información pertinente a los jóvenes

y sus familias, para seleccionar la institución que consideran de mayor calidad

formativa, para realizar

sus estudios universitarios.

Principio 9. Hacer

que las ponderaciones asignadas a los diferentes indicadores (si se usan) sean prominentes y limitar

los cambios en ellas. Los cambios en los pesos

hacen que sea difícil para los usuarios discernir si un resultado de la

institución o del programa cambió en

la clasificación debido a una diferencia inherente o debido a un cambio metodológico. (Berlin

Principles on Ranking of Higher Education Institutions, 2006).

En el ranking 2018, los cuatro indicadores se aplicaron a cada una de las áreas de conocimiento definidas por la OECD (Ciencias Naturales, Ingeniería y Tecnología, Medicina y Ciencias de la Salud, 4. Ciencias Agrarias, Ciencias Sociales y Humanidades), lo que dio como resultado, rankings específicos por área. El ranking general se obtuvo de agregar los rankings por área, otorgando el mismo peso a cada una de las áreas. (Sunedu, 2018, p.92).

En 2020, no se establecieron clasificaciones por área del conocimiento y el cálculo se realizó directamente sobre la institución de manera general. A cada uno de los tres indicadores se le asignó el mismo peso de 33.3% (Sunedu, 2020, p. 108).

Al producirse un cambio significativo en los indicadores y en el mecanismo de ponderación para obtener el puntaje general, no es posible realizar comparaciones objetivas entre los resultados de 2018 y 2020, de manera que no se cumple con lo recomendado en este principio. Esta característica de los rankings Sunedu concuerda con lo planteado como debilidades por Ordorika (2015), Usher y Savino (2006) y Bookstein. et al. (2010).

Principio 10. Preste la debida atención

a las normas éticas y las recomendaciones de buenas prácticas

planteadas en estos principios. Para asegurar la credibilidad de cada ranking, los responsables de recopilar y

utilizar datos y realizar visitas in situ deben ser tan objetivo e imparcial como sea posible.

Principio 14. Aplicar

medidas organizativas que mejoren la credibilidad de las clasificaciones. Estas medidas podrían incluir órganos asesores

o incluso supervisores, preferiblemente

con participación internacional.

En los rankings analizados, las universidades conocen la metodología, cuando se publican los resultados, por lo que el nivel de transparencia durante el proceso de su elaboración es nulo.

Los

autores del informe 2020 y los asesores que contribuyeron con su elaboración, provienen -porque han sido docentes o estudiantes-, en una proporción que supera al 70%, de solo tres universidades, en un sistema

que está compuesto

por más de cien instituciones y que se caracteriza por un alto nivel de competitividad (Sunedu,

2020, páginas de créditos y agradecimientos3). Este

hecho les resta imparcialidad y credibilidad a los resultados del ranking y constituyen violaciones de los

principios 10 y 14. Asimismo, concuerda con lo

expuesto por Delgado

(2012) acerca de la posible

existencia de intereses

entre los especialistas elaboradores de los rankings, lo que podría ser preocupante, aún más tratándose de una institución gubernamental.

Confiabilidad de los resultados del ranking 2020

Se define a la confiabilidad de un instrumento de medición, a la cualidad que debe tener, de reflejar el valor real de la variable medida. Una evidencia de la confiabilidad se puede obtener comparando los resultados con otras mediciones similares.

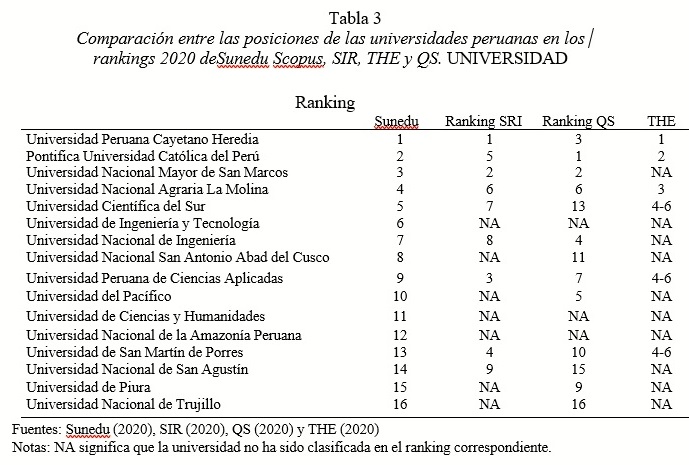

En la Tabla 3 se presenta una comparación entre los resultados del ranking Sunedu 20204 y los rankings internacionales SIR, THE y QS, para el mismo año. En este caso, dado que no todas las universidades están incluidas en los rankings, se ha reducido la cantidad de instituciones analizadas.

3 En esas páginas

están los nombres de los especialistas. Los datos sobre su afiliación y

estudios se encuentran en diferentes páginas en la web.

4 Se utiliza el ranking basado en Scopus, por incluir esta

base de datos un mayor número de publicaciones

además de ser el que utilizan los rankings internacionales con que se comparan.

En el caso de los rankings

internacionales se refieren

a las versiones para Latinoamérica.

Los resultados principales que resultan de estas comparaciones son las

siguientes:

a)

Entre las

primeras 16 universidades del Ranking Sunedu, hay 7 que no han sido clasificadas en el Ranking Scopus, 10 en THE y 4 en QS.

b)

Hay tres universidades que no se encuentran en ninguno de los rankings

internacionales. Sobresale el caso de la Universidad de Ingeniería y

Tecnología, que, a pesar de ello, se encuentra

en el sexto lugar en el Ranking

Sunedu5.

c)

Solo hay

cinco universidades clasificadas en los tres rankings internacionales, sin embargo, dos de ellas no están entre

las primeras en el Ranking

Sunedu, la Universidad Peruana de Ciencias Aplicadas

y la Universidad de San Martín de Porres.

Para analizar el grado de relación estadística entre los rankings internacionales y el Ranking Sunedu, se calculó el coeficiente de correlación Tau de Kendall, por tratarse de variables medidas a nivel ordinal. Los cálculos se realizaron para SIR y QS, no así para THE, pues la cantidad de universidades clasificadas era inferior al 50% del total. Se parte de la hipótesis de que debe existir una correlación positiva y significativa entre los lugares ocupados por las universidades en estos rankings.

Los resultados fueron los siguientes:

Tau de Kendall para posiciones en los rankings Sunedu y SIR, 0.500

Tau de Kendall para posiciones en los rankings Sunedu y QS, 0.648

En el primer caso se obtiene una correlación positiva débil y en el segundo, positiva moderada, por lo que la hipótesis planteada se cumple solo parcialmente. Se esperaría un resultado inverso, pues en el ranking SIR la investigación significa el 50% del resultado total (SIR, 2020) y en QS, el 15% (QS, 2020), por lo que, el primero debería tener mayor similitud con el de la SUNEDU.

Conclusiones

A partir de lo expuesto, es evidente que con rankings centrados en un reducido número de indicadores sobre investigación y, sin considerar otras variables del quehacer universitario, su utilidad se reduce a la mínima expresión, pues no disminuye la asimetría de información sobre la calidad del proceso de formación, por lo que a los jóvenes y padres de familia no les es posible tomar decisiones adecuadas sobre la base de sus resultados. Del mismo modo, tampoco se puede decidir sobre el financiamiento de la investigación, pues los indicadores son limitados y manifiestan sesgos importantes. Su única función ha sido la de clasificar a las universidades basándose en un conjunto de criterios subjetivos seleccionados por un grupo de expertos, provenientes de un reducido número de universidades.

Los rankings Sunedu padecen de una serie de debilidades que violan las recomendaciones de los Principios de Berlín y que reproducen los aspectos negativos de estas clasificaciones, que ya habían sido advertidos por diversos autores especialistas sobre la materia.

Existen diferencias significativas entre los lugares ocupados por las universidades peruanas en el ranking SUNEDU, y los obtenidos en las clasificaciones internacionales. Esto, unido al hecho de que las correlaciones entre ellas son de moderadas a débiles, hacen que su nivel de confiabilidad sea bajo, como instrumento para comparar la calidad de las universidades.

5 En el Ranking

Sunedu WoS se encuentra

en el cuarto lugar (Sunedu,

2020, p. 109).

Referencias

Academic Ranking of

World Universities. Metodología.

Recuperado el 18 de noviembre de 2020, de https://www.shanghairanking.com/ARWUMethodology-2020.html#:~:text=ARWU%20considers%20every%20university%20that,(SSCI)%20are%20also%20included

Berlin Principles on

Ranking of Higher Education Institutions, 2006. Recuperado

el 18 de octubre de 2020, de http://www.ihep.org/sites/default/files/uploads/docs/-pubs/berlinprinciplesranking.pdf

Bookstein. F. L., Seidler,

H. Fieder, M., Winckler, G. (2010).

Too much noise in the Times Higher Education rankings. Scientometrics 85:295–299 DOI

10.1007/s11192-010- 0189-5. Recuperado el 18 de octubre

de 2020, de https://www.ncbi.nlm.nih.gov/pmc/articles/PMC2927316/

CONCYTEC (2020). Reglamento de Calificación, Clasificación y Registro de los Investigadores del Sistema Nacional de Ciencia, Tecnología e Innovación Tecnológica - Reglamento RENACYT. Lima. Recuperado el 18 de octubre de 2020, de https://portal.concytec.gob.pe/images/noticias/ManualdelReglamento-RENAC YT_1.pdf

Delgado, E. (2012).

Cómo se cocinan los rankings

universitarios How to cook the university rankings. Dendra Médica.

Revista de Humanidades, 11(1):43-58 Recuperado el 18 de octubre de 2020 de http://hdl.handle.net/10481/2061

Hazelkorn, E. (2009). Impact of Global

Rankings on Higher Education Research and Production

of Knowledge. UNESCO Forum on Higher

Education, Research and Knowledge.

Occasional Paper No. 15. Recuperado el 27 de octubre de

2020 de https://unesdoc.unesco.org/ark:/48223/pf0000181653

Krüger,

K., Molas, A. (2010). Rankings de Universidades españolas. Ar@cne: Revista electrónica de Recursos en Internet sobre

geografía y Ciencias Sociales. Recuperado el 11 de noviembre de 2020

de https://www.raco.cat/index.php/-Aracne/article/view/19880

Ley 30220. Diario Oficial El Peruano, Lima, 9 de julio de 2014.

Ordorika, Imanol.

(2015). Rankings universitarios. Revista de la educación superior,

44(173), 7-9. Recuperado el 18 de octubre de 2020, de http://www.scielo.org.-mx/scielo.php?script=sci_arttext&pid=S018527602015000100001&lng=es&tlng=es

Piscoya, L, (2007). Ranking

Universitario en el Perú. Plan Piloto. Lima: ANR. Recuperado el 18 de octubre

de 2020, de http://flacso.redelivre.org.-br/files/2012/08/747.pdf

QS (2020). QS Latin America University Rankings 2020. Methodology. Recuperado el 28 de octubre de 2020 de https://www.topuniversities.com/latinamericarankings/-methodology

SIR (2020). Scimago Institutions Ranking Latin America. Recuperado el 28 de octubre de 2020 de https://www.scimagoir.com/rankings.php?sector=Higher%20educ.&-country=Latin%20America

Sistema de información universitaria (SIU). Busca universidades (28 de

octubre de 2020). Recuperado de https://www.tuni.pe/universidades?page=1

Sunedu (2016). El

modelo de licenciamiento y su implementación en el Sistema Universitario Peruano. Recuperado el 20 de octubre de 2020, de: https://www.sunedu.gob.pe/condiciones-basicas-de-calidad-2/

Sunedu (2018). Informe

Bienal sobre la Realidad Universitaria Peruana, Recuperado el 18 de octubre

de 2020 de https://cdn.www.gob.pe/uploads/document/file/-747830/Informe-Bienal-sobre- realidad.pdf

Sunedu (2020) II Informe Bienal sobre la Realidad Universitaria en el Perú. Recuperado el 18 de octubre de 2020 de http://repositorio.minedu.gob.pe/handle/MINEDU/6911

THE (2020). The Times Higher Education Latin America University Rankings. Methodology. Recuperado el 28 de octubre de 2020 de https://www.timeshighereducation.com/worlduniversityrankings/worlduniversity-rankings-2020-methodology

Tomás, M., Feixas, M., Bernabeu – Tamayo, M.D., Ruiz, J. Ma, La literatura científica sobre rankings universitarios: una revisión sistemática. REDU, Revista de Docencia Universitaria... Vol. 13 (3), octubre - diciembre 2015, 33-54 ISSN: 1887-4592. Recuperado el 18 de octubre de 2020, de https://core.ac.uk/download/pdf/189115499.pdf

Usher, A., y Savino, M. (2006). Estudio global de los rankings universitarios. Calidad en la Educación, (25), 33-53. Recuperado el 18 de octubre de 2020, de doi: https://doi.org/10.31619/caledu.n25.252